Chatbots zu Forschungszwecken miteinander plaudern lassen

Maschinelle Dialogsysteme sollen sich so menschenähnlich wie möglich verhalten. Nun haben ZHAW-Forschende ein neues Verfahren für die zuverlässige Evaluation solcher Chatbots entwickelt. Sie lassen verschiedene Systeme miteinander sprechen, um sie bewerten zu können.

Sie beantworten im Kundendienst brennende Fragen, assistieren bei unzähligen Dienstleistungen oder sollen vielleicht einfach nur der Unterhaltung dienen. Als virtuelle Ansprechpartner nehmen sogenannte Chatbots im Alltag immer mehr Raum ein. Wie evaluiert man aber zuverlässig, welcher Chatbot sich im Dialog als menschenähnlicher Gesprächspartner bewährt? «Die Beurteilung von Gesprächen ist grundsätzlich schwierig – auf der Ebene von Chatbots noch schwieriger», sagt Don Tuggener. Computerlinguistik gehört zu seinen Forschungsgebieten am ZHAW-Institut für angewandte Informationstechnologie (InIT). «Die Evaluation von Chatbots durch Menschen war bisher nicht nur aufwändig und teuer, sondern auch inkonsistent, weil jeder Mensch eine subjektive Bewertung aufgrund des eigenen Dialogs mit dem Chatbot vornimmt», so Tuggener.

Reproduzierbare und zuverlässige Evaluationsmethode

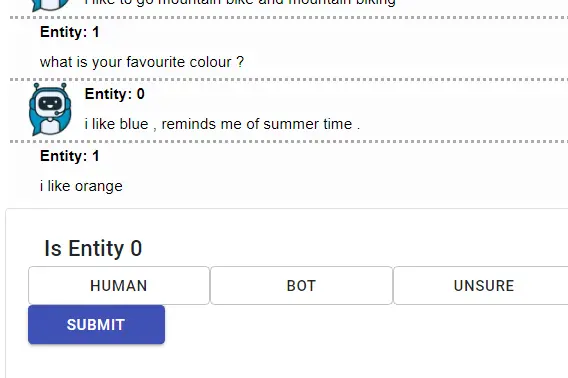

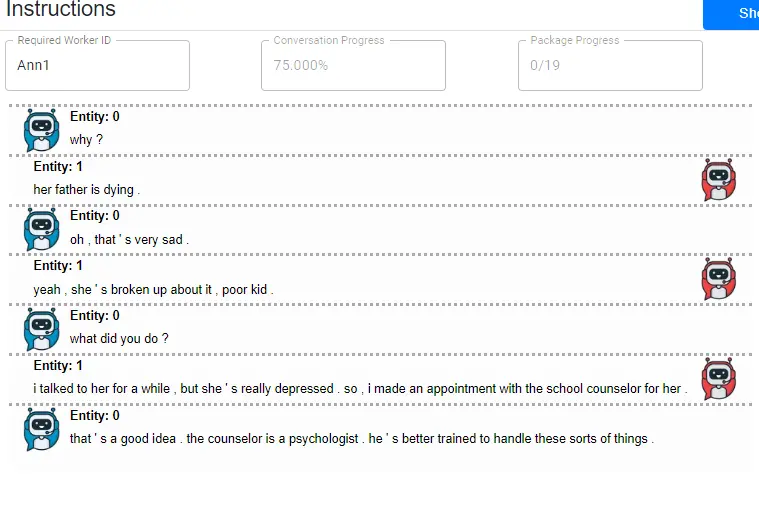

Im Rahmen des übergeordneten EU-Forschungsprojekts LIHLITH haben die Forschenden am InIT eine neue Grundlage für die Bewertung von Chatbots geschaffen. «Spot The Bot» nennen sie ihr Verfahren, in dem unterschiedliche Chatbots miteinander Dialoge führen. «Wir lassen die Chatbots statt mit Menschen mit anderen Chatbots sprechen», erklärt Jan Deriu, Doktorand am InIT. Die Konversationen entstehen somit automatisch, anstatt dass sie eigens von Personen geführt werden müssen. Danach sichten Menschen die Gesprächsprotokolle und sollen die Bots ausfindig machen. «Natürlich haben wir unter die reinen Chatbotdialoge auch noch echte Konversationen mit Menschen gemischt», so Deriu. «Und wir lassen die Dialoge abschnittsweise beurteilen, denn nach einiger Zeit wird jeder Chatbot enttarnt. Je länger er aber Menschen täuschen kann, desto besser ist der Chatbot.»

«Die Evaluation von Chatbots durch Menschen war bisher nicht nur aufwändig und teuer, sondern auch inkonsistent.»

ZHAW-Forscher Don Tuggener

Methode an Fachkonferenz erfolgreich vorgestellt

Mit dem neuen Verfahren lassen sich die Chatbots zuverlässig und effizient von Menschen evaluieren. «Wir haben damit ein grosses Problem gelöst, denn bisher war die Evaluation von Dialogsystemen schlecht reproduzierbar, teuer und inkonsistent», sagt Pius von Däniken, wissenschaftlicher Assistent am InIT. Mit ihrer neuen Methode haben die Forscher an der EMNLP als eine der internationalen Top-Konferenzen im Bereich Natural Language Processing eine «Honorable Mention» im Rennen um den Best Paper Award erreicht. «An der EMNLP wurden dieses Jahr 3677 Papers eingereicht und die Acceptance Rate war 22 Prozent», ordnet Don Tuggener den Erfolg ein. «Wir sind mit unserem Paper damit quasi unter den besten fünf gelandet – nicht schlecht für eine angewandte Fachhochschule in internationaler Konkurrenz.»